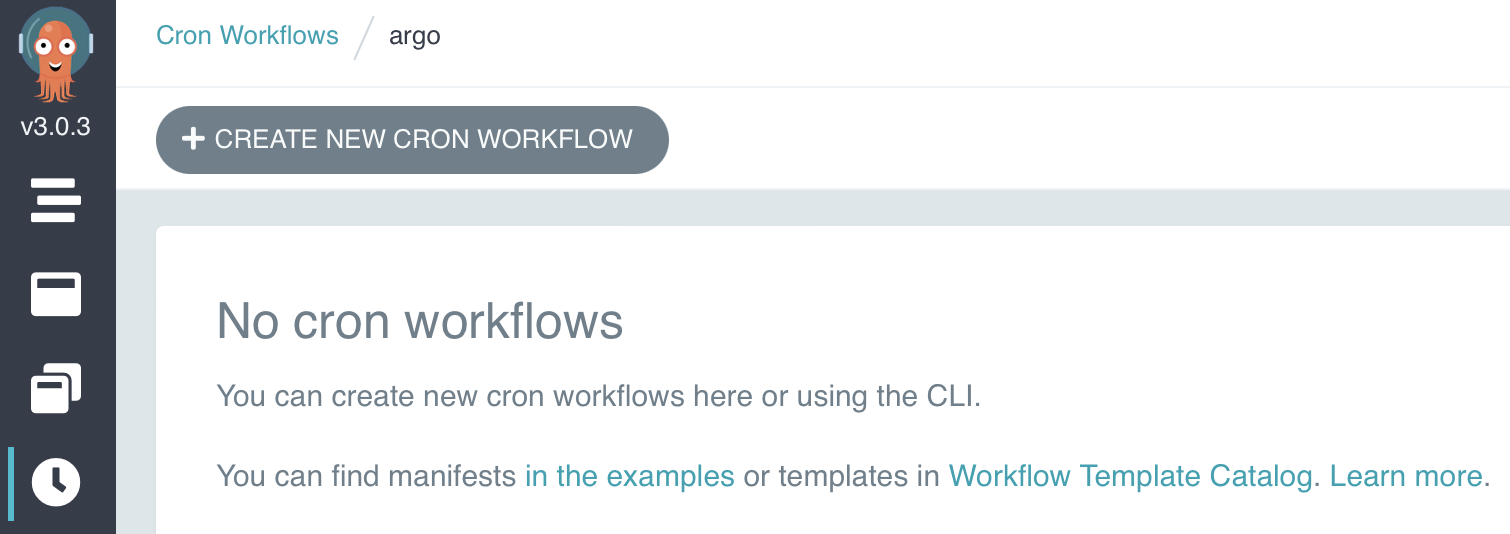

지난 글(https://seokhyun2.tistory.com/86)에서 argo workflow를 로컬에 세팅하는 방법에 대해서 알아보았었는데요. 오늘은 설치한 argo workflow에서 cron workflow를 생성하는 방법에 대해서 한 번 알아보도록 하겠습니다. cron workflow 생성 cron workflow는 정해진 시간에 주기적으로 실행이 되는 workflow입니다. 기본적으로 웹 화면에서, ui로 간단하게 실행할 수 있습니다. 아래에서 왼쪽에 4번째에 시계 아이콘을 선택하면 Cron Workflows 탭에 들어갈 수 있고 그러면 CREATE NEW CRON WORKFLOW 버튼을 눌러서 간편하게도 생성할 수 있습니다. 버튼을 눌러보면, 아래의 내용이 기본 예제로 이미 입력이 되어 있..